DeTinyLLM:通过紧凑的释义转换高效检测机器生成的文本

摘要

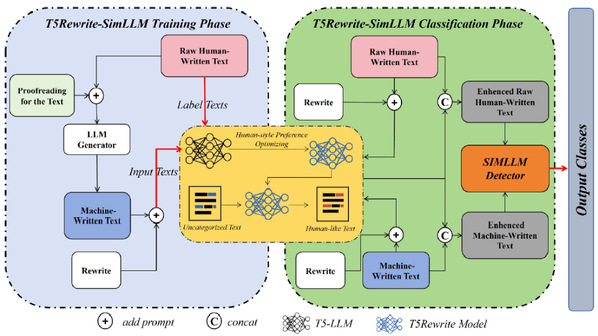

随着人工撰写的文本与机器生成的文本的融合日益加深,如何辨别它们的来源便成为了一个重大挑战,因为先进的大型语言模型(LLM)正越来越多地模仿人类的语言模式。现有的检测方法,如 SimLLM,依靠查询专有的 LLM 进行校对以衡量相似度,这会带来高昂的计算成本和因依赖不断变化的模型更新而产生的不稳定性。为了解决这些局限性,我们提出了 DeTinyLLM,这是一个新颖的框架,它利用融合驱动的紧凑变体模型来进行高效且稳定的检测。首先,我们训练一个轻量级转换模型(例如,经过微调的 T5-large),将机器生成的文本重写为类似人类的文本,通过语法和语义特征的迭代融合有效地“去 AI 化”它。对于检测,输入文本及其重写版本通过混合神经网络进行融合并分类,利用人类和机器文本之间的差异模式。在不同数据集上的实验表明,DeTinyLLM 实现了最先进的准确率(在 ROC-AUC 上超过 SimLLM 4.3%),同时将推理延迟降低了 77.2%。通过摒弃对专有语言模型的依赖,并整合多层次的语言信号融合技术,这项工作为人工智能生成文本检测系统的实际应用提供了可扩展且经济高效的解决方案。

作者

谈世磊,周勇城,刘浩翔,王雪松,陈思,龚伟

期刊\会议

Information Fusion [Link]

关键词

机器生成文本检测;文本信息融合;DeTinyLLM